《DDPG算法实现双积分系统控制与MATLAB程序视频》共2章13节视频,总学时87分钟,合1.4小时。它是《深度强化学习(DRL)及其应用与MATLAB程序详解视频》(合29.7小时)的第12章。本课程是利用DDPG算法对论文常用模型——双积分系统控制的应用实例,涉及程序详解及论文用图与误差分析等问题,这是一个完整的论文毕设写作和科研实例。

主要内容包括:视频课程内容介绍及慎拍不拍建议与辅导答疑说明,双积分系统简介,对程序解读、分析、加注和详解,对程序用的重要命令给出详解,详细讲解了8点可改之处及其可改建议,针对双积分系统讲解了模型扩展的方向,针对DDPG算法提出了算法扩展的思路,重点讲解了5个思考问题,用MATLAB自带的DDPG算法程序再解双积分系统控制策略问题,提供了训练阶段的回报与平均回报图像,提供了仿真测试DDPG智能体控制回合的状态、动作和奖励的图像,满足论文写作和科研所需的数据与图像。整个过程形成了一个“科学研究实际问题”的典型案例。

全部免费提供MATLAB程序,免费提供PPT课件,免费提供辅导答疑。

【如何为己所用】

(1)对自己问题选定出状态、连续动作和奖励函数。

(2)只需将自己问题的状态、连续动作和奖励函数替换所提供程序的关键字DoubleIntegrator-Continuous或自己创建环境即可,完整得到论文写作所需的数据、论文用图。

(3)该例程可以推广到求解其他的【连续动作】的强化学习问题。

【前期基础】衔接课程

(1)《强化学习的基本概念与理论》

(2)《DDPG算法及其步骤与优缺点分析》

【后期选学】相关课程推荐

(1)《PG算法自带函数程序详解双积分系统控制问题》

(2)《连续动作问题用DDPG算法自编工具箱函数程序实现控制》

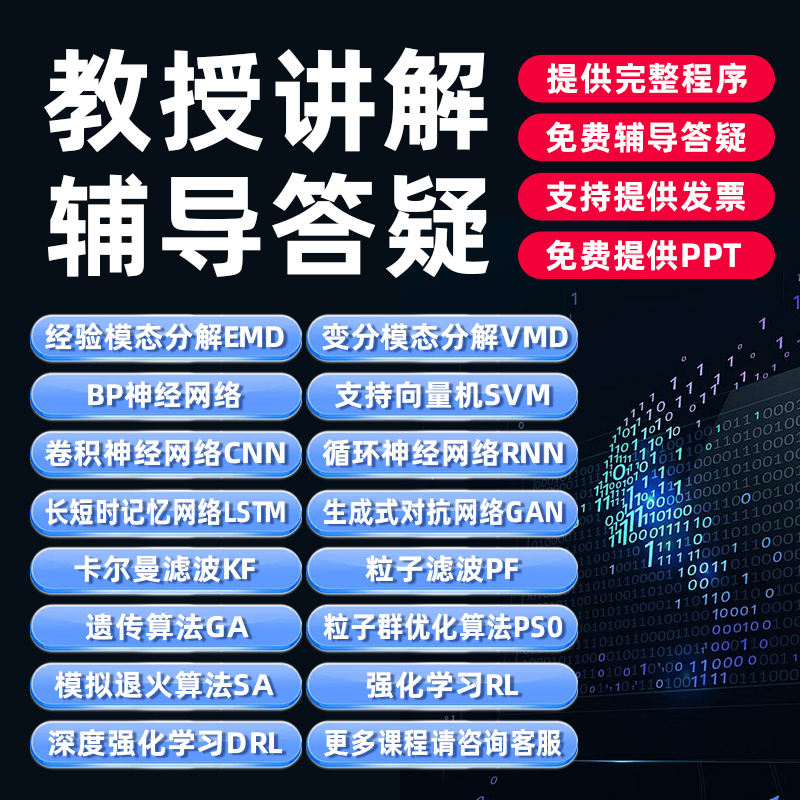

【强化学习类算法视频课程】推荐

(1) 强化学习(RL)及其应用与MATLAB程序详解视频;

(2) 深度强化学习(DRL)及其应用与MATLAB程序详解视频;

(3) 强化学习设计器使用与MATLAB程序详解视频;

(4) 如何创建强化学习问题的MATLAB环境及程序详解视频;

(5) 如何创建强化学习问题的Simulink环境及程序详解视频。

一、学习指导方案

1、全部视频都在网上。请首先按照视频文件序号由小到大(若前序号相同,说明视频内容密切联系,再看后面序号大小)的序号观看,保证内容由浅入深地顺序学习。

2、在看视频的同时,利用【倍速】【暂停】【倒回】操作,最好运行程序文件。

3、将存在的问题记录下来,看看视频是否讲解。对视频还是没有讲解的问题,尽快问【面对面数学】答疑。

4、视频观看结束后,看看PPT课件,复习、巩固学习效果。

5、视频清晰度:(1)建议屏幕分辨率设置为1920x1080 或者屏幕分辨率1280x720。(2)全屏播放。这样看视频更加清晰。

6、倍速播放:现在【淘宝新平台】已经具备【倍速播放】视频功能。

四、目 录

第一章 视频课程内容介绍及慎拍不拍建议与辅导答疑说明(29+10分钟)

1、先看全面讲解9个关键重点问题和店主预言先告必看第三版(25+4分钟)

2、DRL1_视频讲些什么及能干什么与程序演示结果(5分钟,网络上免费“试看”)

3、VMD1_2MATLAB程序使用说明及亮点特点介绍(2分钟,网络上免费“试看”)

4、VMD2_1慎拍不拍建议与辅导答疑说明(3分钟,网络上免费“试看”)

第二章 深度强化学习算法教学顾虑及重点基础知识复习(89分钟)

5、DRL4_1教学顾虑与教学对策说明(7分钟,网络上免费“试看”)

6、DRL4_2复习BP神经网络层结构及工作流程(15分钟)

7、DRL4_3复习卷积神经网络五层关系及输出(7钟,网络上免费“试看”)

8、DRL4_4复习4个常用优化器公式及衰减因子知识(16分钟)

9、DRL4_5复习Q学习算法实施步骤及优缺点(14分钟)

10、DRL4_6复习策略迭代算法步骤及优缺点(16分钟)

11、DRL4_7复习值迭代算法步骤及优缺点与二者区别(14分钟)

第三章 自带自定义函数创建车杆平衡控制问题环境(139分钟)

12、DRL5_1学习目的及手推车杆平衡问题细说(13分钟,有程序)

13、DRL5_2MDP五要素与车杆平衡问题的对应分析(7分钟,有程序)

14、DRL5_3思考常用3个术语及其含义(6分钟,有程序)

15、DRL5_4自学程序及rlNum和rlFin函数功能(12分钟,有程序)

16、DRL5_5函数myResetFun功能详解(7分钟,有程序)

17、DRL5_6环境常量及平衡系统运动方程介绍(13分钟,有程序)

18、DRL5_7函数myStepFun语句详解(10分钟,有程序)

19、DRL5_8用自定义函数名得到下一记录信号(12分钟,有程序)

20、DRL5_9用函数句柄得到下一时刻记录信号(16分钟,有程序)

21、DRL5_10可改9处程序及其可改建议(11分钟,有程序)

22、DRL5_11参数设置及回合起始点详解(9分钟,有程序,网络上免费“试看”)

23、DRL5_12自定义函数联合应用程序详解(13分钟,有程序)

24、DRL5_13思考如何使用程序等4个问题及总结(10分钟,有程序)

第四章 DQN算法及其步骤与优缺点分析(115分钟)

25、DRL6_1学习目的及DQN算法的输入输出(12分钟)

26、DRL6_2研究存在问题及解决办法与经验回放(16分钟)

27、DRL6_3MNet和TNet及参数传递(8分钟)

28、DRL6_4DQN算法2013年版步骤详解(12分钟)

29、DRL6_5DQN2015版算法步骤详解(11分钟)

30、DRL6_6DQN算法三大改进思路及网址(6分钟)

31、DRL6_7论文与科研思路12点及总结(16分钟)

32、DRL6_8算法流程图及损失函数构造逻辑关系(13分钟,网络上免费“试看”)

33、DRL6_9创新点及优点与缺点介绍分析(8分钟)

34、DRL6_10思考DQN适用条件等问题及总结(13分钟)

第五章 DQN算法代码程序详解车杆平衡控制问题(380分钟)

35、DRL7_1学习目的及车杆平衡控制问题简介(12分钟)

36、DRL7_2自学建议及CPInit函数详解(10分钟,有程序)

37、DRL7_3AgInit和Reward函数详解(18分钟,有程序)

38、DRL7_4AgInit再详解及经验池初始化(12分钟,有程序)

39、DRL7_5CPReset函数详解及记录变量初始化(14分钟,有程序)

40、DRL7_6tcegre函数详解及得到Qmax和动作(15分钟,有程序)

41、DRL7_7CPEqs函数和ode45详解及新状态(15分钟,有程序)

42、DRL7_8PMove函数详解及各步训练过程分析(11分钟,有程序)

43、DRL7_9两网络复制及随机取训练样本(13分钟,有程序)

44、DRL7_10动作标号与400个状态整形(11分钟,有程序)

45、DRL7_11CalQtar详解及Q_target(12分钟,有程序)

46、DRL7_12主网络训练及回合终止条件(11分钟,有程序)

47、DRL7_13DQN算法步骤对应出现语句(15分钟,有程序)

48、DRL7_14程序7_1完整运行及结果解读分析(12分钟,有程序)

49、DRL7_15可改前面10处及其建议(15分钟,有程序)

50、DRL7_16可改后部10处及其建议(5分钟,有程序,网络上免费“试看”)

51、DRL7_17程序7_1结果4图像解读分析(14分钟,有程序)

52、DRL7_18原始程序7_1完整运行结果及3个方案(7分钟,有程序)

53、DRL7_19程序7_4小阈值及其结果分析(8分钟,有程序)

54、DRL7_20改动位置与角度正态奖励及结果分析(11分钟,有程序)

55、DRL7_21程序7_5改动关键及结果分析(15分钟,有程序)

56、DRL7_22程序7_6综合改动及其结果分析(14分钟,有程序)

57、DRL7_23结果5个对比及3个数值指标(14分钟,有程序)

58、DRL7_24回合控制时长及快速收敛数值指标(12分钟,有程序)

59、DRL7_25局部平稳性及持续控制回合数指标(9分钟,有程序)

60、DRL7_26完整回合与不完整回合及原因分析(20分钟,有程序)

61、DRL7_27模型扩展之6方面介绍(5分钟,有程序,网络上免费“试看”)

62、DRL7_28算法扩展之6点推荐介绍(5分钟,有程序)

63、DRL7_29思考状态动作和奖励及注意问题(7分钟,有程序)

64、DRL7_30思考两个网络关系及最终结果(12分钟,有程序)

65、DRL7_31思考贪婪策略阈值及奖惩关系(11分钟,有程序)

66、DRL7_32思考数值指标与使用程序及总结(15分钟,有程序)

第六章 DQN算法自带函数程序再解车杆平衡控制问题(133分钟)

67、DRL8_1学习目的及问题差别与自学建议(10分钟,有程序)

68、DRL8_2子函数rlPreEnv功能及自己问题引入(16分钟,有程序)

69、DRL8_3网络dnn结构及其含义分析(17分钟,有程序)

70、DRL8_4子函数critic及其可选参数设置(10分钟,有程序)

71、DRL8_5子函数rlDQNAg及其可选参数设置(14分钟,有程序)

72、DRL8_6train和sim过程详解分析(13分钟,有程序)

73、DRL8_7train过程动画详解与分析(11分钟,有程序,网络上免费“试看”)

74、DRL8_8可改7处及其可改建议(10分钟,有程序)

75、DRL8_9tranStats数据及论文用3图像分析(5分钟,有程序)

76、DRL8_10导入agent和env数据及图像分析(14分钟,有程序)

77、DRL8_11实际应用DQN结果的过程模拟(13分钟,有程序)

78、DRL8_12思考自带函数程序隐形输出2个问题(12分钟,有程序)

79、DRL8_13思考使用程序等4个问题及总结(15分钟,有程序)

第七章 PG算法及其步骤与优缺点分析(97分钟)

80、DRL9_1学习内容及DQN存在问题与改进算法(10分钟)

81、DRL9_2建立具有回报变量的损失函数(18分钟)

82、DRL9_3损失函数取得及其梯度计算分析(13分钟)

83、DRL9_4目标函数(梯度)6个的产生分析(15分钟)

84、DRL9_5策略梯度算法两类型及7大改进(13分钟)

85、DRL9_6蒙特卡罗策略梯度算法步骤解读(9分钟)

86、DRL9_7PG算法流程图逻辑关系分析(6分钟)

87、DRL9_8PG算法优缺点及思考2题与总结(13分钟,网络上免费“试看”)

第八章 PG算法自带函数程序详解双积分系统控制问题(137分钟)

88、DRL10_1学习目标及双积分系统控制问题说明(12分钟,有程序)

89、DRL10_2自学建议及创建双积分系统环境(11分钟,有程序)

90、DRL10_3rlStoActorRep功能(22分钟,有程序)

91、DRL10_4rlValueRep语法及功能(8分钟,有程序)

92、DRL10_5rlPGAgent语法详解(16分钟,有程序)

93、DRL10_6导入训练好智能体并sim结果(7分钟,有程序)

94、DRL10_7训练过程图像分析变量保存(19分钟,有程序)

95、DRL10_8可改6处及其可改建议(11分钟,有程序,网络上免费“试看”)

96、DRL10_9模型扩展5方面及算法扩展6处(9分钟,有程序)

97、DRL10_10思考怎样使用模板程序(7分钟,有程序)

98、DRL10_11思考应用问题来源与图像分析及总结(15分钟,有程序)

第九章 AC算法及其步骤与优缺点分析(67分钟)

99、DRL11_1学习目的及AC算法解决问题(10分钟)

100、DRL11_2AC算法相关知识及更新公式3点变形(12分钟)

101、DRL11_3AC算法步骤分析及A2C与A3C(19分钟)

102、DRL11_4AC算法流程图及其优缺点与改进(10分钟,网络上免费“试看”)

103、DRL11_5思考AC适用条件3个问题及总结(16分钟)

第十章 AC算法自带函数程序再解车杆平衡控制问题(99分钟)

104、DRL12_1学习目的及车杆平衡控制问题(15分钟,有程序)

105、DRL12_2自学及车杆状态与动作信息(16分钟,有程序)

106、DRL12_3构建评判员和演员网络(10分钟,有程序,网络上免费“试看”)

107、DRL12_4AC智能体创建及模拟结果解读(17分钟,有程序)

108、DRL12_5训练过程动画及其分析结论(12分钟,有程序)

109、DRL12_6可改7处及其可改建议(13分钟,有程序)

110、DRL12_7扩展问题及思考如何调参与总结(16分钟,有程序)

第十一章 DDPG算法及其步骤与优缺点分析(139分钟)

111、DRL13_1DDPG学习目的及我们算法学习过程(8分钟)

112、DRL13_2DDPG算法产生原因及基本思想(11分钟,网络上免费“试看”)

113、DRL13_3随机性策略与确定性策略及激活函数(18分钟)

114、DRL13_4DQN与DDPG联系及AC结构(13分钟)

115、DRL13_5DDPG网络优化与Loss及最优策略(6分钟)

116、DRL13_6目标网络及网络参数更新方法(14分钟)

117、DRL13_7行为策略与OU过程噪声(8分钟)

118、DRL13_8DDPG算法步骤详解分析(13分钟)

119、DRL13_9DDPG算法流程图17点讲解(12分钟)

120、DRL13_10评判员Loss与演员梯度公式分析(11分钟)

121、DRL13_11DDPG算法创新点与优缺点简介(9分钟)

122、DRL13_12思考DDPG适用条件及4个网络作用(16分钟)

第十二章 DDPG算法自带函数程序再解双积分系统控制问题(76分钟)

123、DRL14_1学习目的及自学建议提纲(6分钟,有程序)

124、DRL14_2连续与离散动作变量比较及动作分量(8分钟,有程序)

125、DRL14_3网络图层及连接结构与显示(11分钟,有程序)

126、DRL14_4critic和actor网络结构及表示(7分钟,有程序)

127、DRL14_5创建rlDDPGAgent(14分钟,有程序)

128、DRL14_6应用训练好的智能体测试结果(4分钟,有程序)

129、DRL14_7实际训练及图像分析与结果测试(6分钟,有程序)

130、DRL14_8可改8处程序语句及其可改建议(7分钟,有程序)

131、DRL14_9模型6个方向扩展及算法5点扩展(7分钟,有程序)

132、DRL14_10思考不同语法结果比较及总结(6分钟,有程序)

第十三章 连续状态离散动作问题用3个算法自编工具箱函数程序实现控制(147分钟)

133、DRL15_1学习目的与3种程序及其用途(14分钟,有程序)

134、DRL15_2车杆平衡控制问题及其应用扩展方向(9分钟,有程序)

135、DRL15_3自定义初始状态myResetFun函数(8分钟,有程序)

136、DRL15_4自定义单步函数myStepFun设置(18分钟,有程序)

137、DRL15_5自编函数程序用DQN算法解车杆控制问题(19分钟,有程序)

138、DRL15_6AC算法自编函数程序求解车杆平衡问题(8分钟,有程序)

139、DRL15_7应用问题改变及程序改动与说明(8分钟,有程序)

140、DRL15_8PG程序7处改动原因及多个图像分析(16分钟,有程序)

141、DRL15_9控制能力与应变能力2个数值指标详解(17分钟,有程序)

142、DRL15_10泛化能力及持续控制能力数值指标(9分钟,有程序)

143、DRL15_11思考如何使用程序及8个数值指标(14分钟,有程序)

144、DRL15_12总结改写应用问题及利用数值指标问题(7分钟,有程序)

第十四章 连续动作问题用DDPG算法自编工具箱函数程序实现控制(56分钟)

145、DRL16_1连续动作问题用DDPG算法求解(17分钟,有程序)

146、DRL16_2DDPG算法求解连续动作问题较好方案(12分钟,有程序)

147、DRL16_3连续状态及动作的DDPG算法多结构程序(12分钟,有程序)

148、DRL16_4思考使用程序等5个问题及总结(15分钟,有程序)

五、下载文件

附件1_必先看_深度强化学习及程序视频学习指导.doc

附件2_深度强化学习与程序视频_PPT课件.rar

附件3_深度强化学习全部程序m_郑一.rar

六、各个算法及其链接到淘宝平台

点击下列链接,即可进入淘宝教育【视频播放】页面,有免费的“试看视频”,可以“倍速”播放。

留意:【视频播放】页面右下角到【淘宝店铺详情页】拍宝贝。详情页介绍了你所关心的所有问题。

1、第2版卡尔曼滤波与应用和MATLAB程序详解视频科研算法辅导答疑

2、第2.5版粒子滤波与应用和MATLAB程序详解视频科研技术算法

6、非局部均值滤波类算法与应用和MATLAB程序详解视频科研技术算法

8、随机变量数据分析与处理和MATLAB程序详解视频教程

13、支持向量机(SVM)及其分类识别应用与MATLAB程序详解视频

15、遗传算法优化BP神经网络及其应用与MATLAB程序详解视频

16、模拟退火算法(SA)及其应用与MATLAB程序详解视频

17、第2版变分模态分解(VMD)及其应用与MATLAB程序详解视频

https://jiaoyu.taobao.com/course/TBJY_3414002?spm=qingketang.24510471.0.0.15d151f85pWtbm

20、生成式对抗网络(GAN)及其应用与MATLAB程序详解视频

https://jiaoyu.taobao.com/course/TBJY_3084112?spm=qingketang.24510471.0.0.77f351f8J3ewfJ

21、强化学习(RL)及其应用与MATLAB程序详解视频

https://jiaoyu.taobao.com/course/QKT_3179062?spm=qingketang.24510471.0.0.340751f83r7clZ

22、深度强化学习(DRL)及其应用与MATLAB程序详解视频

https://jiaoyu.taobao.com/course/QKT_3551159?spm=qingketang.24510471.0.0.20d051f8jo5prn

23、辅助正则粒子滤波与应用和MATLAB程序详解视频

https://jiaoyu.taobao.com/course/QKT_3675002?spm=qingketang.24510471.0.0.1e1d51f8oJ3B1f

24、第3版Python程序及傅里叶变换与应用详解视频

https://jiaoyu.taobao.com/course/QKT_4862067?spm=qingketang.24510471.0.0.41fc51f8l9DBBC

25、交叉验证优化3个神经网络参数与应用和MATLAB程序详解视频

https://jiaoyu.taobao.com/course/QKT_4660145?spm=2013.1.0.0.7e182286IIvqif

26、粒子群优化支持向量机和MATLAB程序详解视频

https://jiaoyu.taobao.com/course/QKT_4498113?spm=qingketang.24510471.0.0.291a51f8ZVY9Rj

https://jiaoyu.taobao.com/course/QKT_5063115?spm=qingketang.24510471.0.0.2f2051f8bHrtcZ

https://jiaoyu.taobao.com/course/QKT_5341013?spm=qingketang.24510471.0.0.429851f8WFtx4g

https://jiaoyu.taobao.com/course/QKT_5262003?spm=qingketang.24510471.0.0.474651f8RlQkTZ

https://jiaoyu.taobao.com/course/QKT_5285024?spm=qingketang.24510471.0.0.70b951f8926O6T

https://jiaoyu.taobao.com/course/QKT_4422023?spm=qingketang.24510471.0.0.433651f8ynib9r

https://www.bilibili.com/cheese/play/ss20232

https://www.bilibili.com/cheese/play/ss20138

https://www.bilibili.com/cheese/play/ss23543

https://www.bilibili.com/cheese/play/ss19900